L’accélération du progrès technologique a été l’une des marques de la fin du XXe siècle. De nombreuses personnalités pensent que nous sommes au bord d’une rupture comparable à l’arrivée de l’homme sur terre. Un moment où l’évolution technologique donnera lieu à l’apparition de machines plus intelligentes que les êtres humains.

Au-delà de cette singularité, nous assisterons à une accélération des créations technologiques non plus par l’homme mais par la technologie elle même. Il est ici question d’intelligence artificielle. Le progrès technologique serait alors si rapide qu’il dépasserait la capacité des humains à le contrôler, le prédire et à le comprendre.

La singularité technologique est souvent considérée comme un événement, à l’image de la singularité gravitationnelle, au-delà duquel le cours futur de l’histoire de l’homme devient imprévisible et insondable .

La première utilisation du terme « singularité » dans ce contexte a été faite en 1958 par le mathématicien et physicien hongrois John von Neumann. « L’une des conversations avait pour sujet l’accélération constante du progrès technologique et des changements du mode de vie humain, qui semble nous rapprocher d’une singularité fondamentale de l’histoire de l’évolution de l’espèce, au-delà de laquelle l’activité humaine, telle que nous la connaissons, ne pourrait se poursuivre. » – Stanislaw Ulam, au sujet d’une conversation avec John von Neumann.

Ce postulat a été ensuite popularisé par le mathématicien Vernor Vinge, notamment dans un article de 1993 qui fut largement diffusé, The Coming Technological Singularity : How to Survive in the Post-Human Era.

Il existe de nombreux domaines par lesquels ces percées peuvent émerger: l’informatique, la génétique, la nanotechnologie, la robotique ou encore l’intelligence artificielle au sens large. Toutes ces branches dépendent très largement des progrès liés à la construction des ordinateurs toujours plus rapides d’années en années.

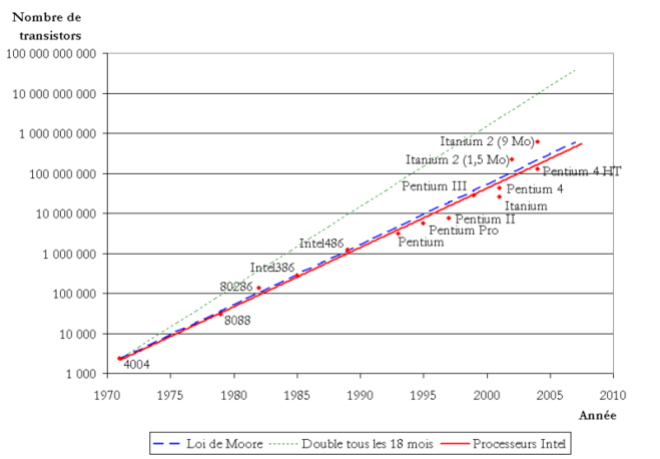

La singularité technologique est donc très largement basée sur la célèbre loi empirique de Moore décrivant dès 1965 que le nombre de transistors de la dernière gamme de processeur est doublé tous les deux ans. L’amélioration de la finesse de gravure de ces transistors permet de faire grimper le nombre d’éléments qu’il est possible de placer sur une même puce. Cela a pour résultat l’augmentation des performances à coût constant. Jusqu’à présent cela c’est plus moins vérifié.

Il est relativement simple de s’en rendre compte. L’Apollo Guidance Computer, l’ordinateur de vol du module lunaire de 1969, exécutait les instructions à une vitesse de 1 Mhz soit la puissance d’une calculatrice bas de gamme actuelle. Avec une puissance estimée à 1,5-1,65 gigaflops, l’iPad 2 aurait ainsi pu rester dans la liste des 500 supercalculateurs les plus puissants du monde jusqu’en 1994. Le Galaxy S6 de Samsung est cinq fois plus puissant que la PlayStation 2. Ou plus récemment l’Apple Watch est deux plus rapide que l’iPhone 4.

Une grande inconnue demeure: Quand la singularité aurait-elle lieu?

Difficile à dire tant nous sommes loin de comprendre le fonctionnement du cerveau humain. Le débat est donc ouvert. Certains annoncent 2045, certains 2100, et d’autres n’y croient même pas. Mais rien ne sert de tenter de prédire la date exacte. Compte tenu de la nature exponentielle de l’accélération du changement technologique, il est tout aussi difficile de prédire le monde de 2050 aujourd’hui en 2015, qu’il aurait été d’imaginer 2015 depuis l’an 1200.